ChatGPT محتوای جامع و قابل قبولی تولید می کند دقیق.

اما محققان، هنرمندان و اساتید نسبت به کاستیهایی هشدار میدهند که از کیفیت محتوا میکاهد.

در این مقاله، ۱۱ مضرات محتوای ChatGPT را بررسی خواهیم کرد. بیایید شیرجه بزنیم.

۱. استفاده از عبارت آن را به عنوان غیر انسانی قابل تشخیص می کند

محققانی که نحوه شناسایی محتوای تولید شده توسط ماشین را مطالعه می کنند، الگوهایی را کشف کرده اند که آن را غیرطبیعی می کند.

یکی از این ویژگیها این است که چگونه هوش مصنوعی با اصطلاحات مبارزه میکند.

اصطلاح عبارت یا اصطلاحی است که معنای مجازی به آن متصل شده است، برای مثال، “هر ابری یک پوشش نقره ای دارد.”

فقدان اصطلاحات در یک قطعه محتوا میتواند سیگنالی باشد که محتوا توسط ماشین تولید شده است – و این میتواند بخشی از یک الگوریتم تشخیص باشد.

این همان چیزی است که مقاله تحقیقاتی ۲۰۲۲ استحکام متخاصم ویژگیهای عصبی-آماری در تشخیص ترانسفورماتورهای مولد درباره این ویژگی عجیب در محتوای تولید شده توسط ماشین میگوید:

«ویژگیهای عبارتی پیچیده بر اساس فراوانی کلمات و عبارات خاص در متن تجزیهوتحلیلشده است که بیشتر در متن انسانی دیده میشود.

…از میان این ویژگیهای پیچیده عبارتی، ویژگیهای اصطلاحی بیشترین قدرت پیشبینی را در تشخیص مدلهای مولد فعلی حفظ میکنند.”

این ناتوانی در استفاده از اصطلاحات به ایجاد صدای خروجی ChatGPT و خواندن غیر طبیعی کمک میکند.

۲. ChatGPT فاقد قابلیت بیان

است

هنرمندی در مورد اینکه چگونه خروجی ChatGPT از هنر تقلید می کند، اما فاقد کیفیت واقعی است، نظر داد. بیان هنری.

بیان عمل انتقال افکار یا احساسات است.

خروجی ChatGPT شامل عبارات نیست، فقط کلمات است.

نمیتواند محتوایی تولید کند که افراد را از نظر احساسی در همان سطحی که یک انسان میتواند تحت تأثیر قرار دهد – زیرا هیچ افکار یا احساسات واقعی ندارد.

نیک کیو هنرمند موسیقی، در مقاله پست را در خبرنامه Red Hand Files خود ارسال کرد، در مورد غزل ChatGPT که برای او ارسال شده بود، که به سبک نیک کیو ساخته شده بود، نظر داد.

او نوشت:

“آنچه یک آهنگ عالی را عالی می کند، شباهت زیاد آن به یک اثر قابل تشخیص نیست.

…این رویارویی نفسگیر با آسیبپذیری، خطرناک بودن، کوچکیاش است که در برابر حسی از کشف تکاندهنده ناگهانی قرار میگیرد. این کنش هنری رستگارانه است که قلب شنونده را به هیجان می آورد، جایی که شنونده در کار درونی آهنگ خون خود، مبارزه خود، رنج خود را می شناسد.»

Cave اشعار ChatGPT را تمسخر نامید.

این غزل ChatGPT است که شبیه غزل نیک کیو است:

«من خون فرشتگان را روی دستانم دارم

من آتش جهنم را در چشمانم دارم

من پادشاه پرتگاه هستم، من فرمانروای تاریکی هستم

من همانی هستم که آنها از او می ترسند، در سایه هایی که می ترسند. wrap”>

و این یک غزل واقعی نیک کیو است ( برادر، جام من خالی است):

“خب من روی رنگین کمان ها سر خوردم

من از ستاره ها تاب می خوردم

حالا این بدبخت در لباس گدا

فنجانش را از روی میله ها می کوبد

ببین، این جام من خالی است!

به نظر می رسد من خواسته هایم را نادرست کرده ام

به نظر می رسد دارم خاکستر را جارو می کنم

از همه آتش سوزی های قبلی من”

به راحتی می توان فهمید که شعر تولید شده توسط ماشین شبیه شعر هنرمند است، اما در واقع چیزی را منتقل نمی کند.

اشعار نیک کیو داستانی را بیان میکند که با ترس، میل، شرم، و فریب عمدی فردی که در آهنگ صحبت میکند طنینانداز میشود. این افکار و احساسات را بیان می کند.

به راحتی می توان فهمید که چرا نیک کیو آن را تمسخر می نامد.

۳. ChatGPT اطلاعات بینش تولید نمی کند

یک مقاله منتشر شده در The Insider به نقل از یکی از دانشگاهیان اشاره کرد که مقالات دانشگاهی تولید شده توسط ChatGPT فاقد بینش در مورد موضوع هستند.

ChatGPT موضوع را خلاصه می کند، اما بینش منحصر به فردی از موضوع ارائه نمی دهد.

انسانها از طریق دانش و همچنین از طریق تجربه شخصی و ادراکات ذهنی خود خلق می کنند.

پروفسور کریستوفر بارتل از دانشگاه ایالتی آپالاچی توسط The Insider نقل میکند که اگرچه مقاله ChatGPT ممکن است دارای کیفیتهای دستوری بالا و ایدههای پیچیده باشد، اما همچنان فاقد بینش است.

بارتل گفت:

«آنها واقعاً کرکی هستند. هیچ زمینه ای وجود ندارد، هیچ عمق یا بینشی وجود ندارد.”

Insight مشخصه یک مقاله خوب انجام شده است و این چیزی است که ChatGPT در آن خوب نیست.

این فقدان بینش چیزی است که باید هنگام ارزیابی محتوای تولید شده توسط ماشین در نظر داشت.

۴. ChatGPT بیش از حد کلمه ای است

یک مقاله تحقیقاتی منتشر شده در ژانویه ۲۰۲۳ الگوهایی را در محتوای ChatGPT کشف کرد که باعث میشود برای کاربردهای حیاتی کمتر مناسب است.

عنوان مقاله، چقدر به متخصصان انسانی ChatGPT نزدیک است؟ مجموعه مقایسه، ارزیابی، و تشخیص.

تحقیق نشان داد که انسانها در بیش از ۵۰ درصد از سؤالات مربوط به امور مالی و روانشناسی پاسخهای ChatGPT را ترجیح میدهند.

اما ChatGPT در پاسخ به سؤالات پزشکی شکست خورد زیرا انسانها پاسخهای مستقیم را ترجیح میدادند – چیزی که هوش مصنوعی ارائه نکرد.

محققان نوشتند:

“…ChatGPT از نظر مفید بودن برای دامنه پزشکی در انگلیسی و چینی ضعیف عمل می کند.

ChatGPT اغلب پاسخهای طولانی به مشاوره پزشکی در مجموعه دادههای جمعآوریشده ما میدهد، در حالی که متخصصان انسانی ممکن است مستقیماً پاسخها یا پیشنهاداتی را ارائه دهند، که ممکن است تا حدی توضیح دهد که چرا داوطلبان پاسخهای انسانی را در حوزه پزشکی مفیدتر میدانند.

ChatGPT تمایل دارد یک موضوع را از زوایای مختلف پوشش دهد، که وقتی بهترین پاسخ مستقیم باشد، آن را نامناسب می کند.

بازاریابانی که از ChatGPT استفاده میکنند باید به این نکته توجه داشته باشند زیرا بازدیدکنندگان سایتی که نیاز به پاسخ مستقیم دارند، از یک صفحه وب پرمخاطب راضی نمیشوند.

و موفق باشید در رتبهبندی یک صفحه بیش از حد پرکلام در قطعههای ویژهGoogle >، جایی که یک پاسخ مختصر و واضح که میتواند در Google Voice به خوبی کار کند، ممکن است شانس بیشتری برای رتبهبندی نسبت به یک پاسخ طولانی داشته باشد.

OpenAI، سازندگان ChatGPT، تصدیق می کند که دادن پاسخ های پرمخاطب یک محدودیت شناخته شده است.

در مقاله اعلامیه توسط OpenAI آمده است:

“مدل اغلب بیش از حد پرمخاطب است…”

سوگیری ChatGPT در ارائه پاسخهای طولانی، چیزی است که باید هنگام استفاده از خروجی ChatGPT به آن توجه داشت، زیرا ممکن است با موقعیتهایی مواجه شوید که پاسخهای کوتاهتر و مستقیمتر بهتر است.

۵. محتوای ChatGPT با منطق واضح بسیار سازماندهی شده است

ChatGPT سبک نوشتاری دارد که نه تنها پرمخاطب است، بلکه تمایل به پیروی از الگویی دارد که به محتوا سبک منحصر به فردی میدهد که انسانی نیست.

این ویژگی غیرانسانی در تفاوتهای بین نحوه پاسخدهی انسانها و ماشینها به سؤالات آشکار میشود.

فیلم Blade Runner صحنهای با مجموعهای از سؤالات دارد که برای نشان دادن اینکه سوژهای که به سؤالات پاسخ میدهد انسان است یا اندروید طراحی شده است.

این سوالات بخشی از یک آزمون تخیلی به نام “Voigt-Kampff بود. تست.

یکی از سوالات این است:

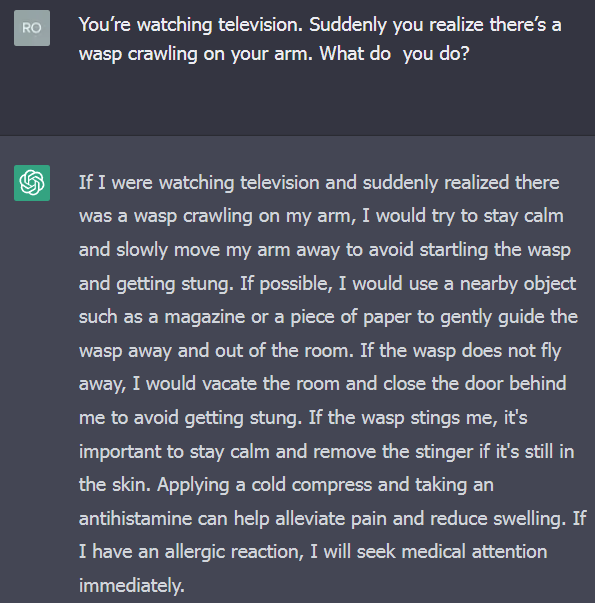

«شما در حال تماشای تلویزیون هستید. ناگهان متوجه می شوید که زنبوری روی بازوی شما می خزد. چه کار میکنید؟»

یک پاسخ عادی انسان این است که چیزی بگوید مانند فریاد زدن، راه رفتن در بیرون و ضربه زدن به آن، و غیره.

اما وقتی این سوال را برای ChatGPT مطرح کردم، پاسخی به دقت سازماندهی شده ارائه داد که سؤال را خلاصه می کرد و سپس نتایج منطقی چندگانه ممکن را ارائه داد – عدم پاسخگویی به سؤال واقعی.

عکس صفحه ChatGPT در حال پاسخ دادن به یک سوال تست Voight-Kampff

عکس از ChatGPT، ژانویه ۲۰۲۳

عکس از ChatGPT، ژانویه ۲۰۲۳پاسخ بسیار سازماندهی شده و منطقی است و به آن احساس بسیار غیرطبیعی می دهد که نامطلوب است.

۶. ChatGPT بیش از حد مفصل و جامع است

ChatGPT به گونهای آموزش داده شده است که وقتی انسانها از پاسخ خوشحال میشوند به دستگاه پاداش میدهد.

ارزیابیکنندگان انسانی تمایل داشتند پاسخهایی را ترجیح دهند که جزئیات بیشتری داشته باشند.

اما گاهی اوقات، مانند یک زمینه پزشکی، پاسخ مستقیم بهتر از پاسخ جامع است.

این بدان معناست که وقتی این ویژگیها مهم هستند، باید از دستگاه خواسته شود که جامعتر و مستقیمتر باشد.

از OpenAI:

“این مسائل ناشی از سوگیری در داده های آموزشی است (مربی ها پاسخ های طولانی تر را ترجیح می دهند که جامع تر به نظر می رسند) و مسائل شناخته شده بیش از حد بهینه سازی.”

۷. ChatGPT دروغ می گوید (حقایق توهم زده)

مقاله تحقیقاتی ذکر شده در بالا، چقدر ChatGPT به متخصصان انسانی نزدیک است؟، اشاره کرد که ChatGPT تمایل به دروغگویی دارد.

گزارش می کند:

«هنگام پاسخ به سؤالی که نیاز به دانش حرفهای از یک زمینه خاص دارد، ChatGPT ممکن است حقایقی را برای پاسخ دادن به آن جعل کند…

به عنوان مثال، در سؤالات حقوقی، ChatGPT ممکن است برخی مقررات قانونی غیرموجود را برای پاسخ به سؤال ابداع کند.

…علاوه بر این، وقتی کاربر سؤالی را مطرح میکند که پاسخی ندارد، ChatGPT ممکن است برای ارائه پاسخ، حقایقی را جعل کند.»

وبسایت Futurism مواردی را مستند کرده است که محتوای تولید شده توسط ماشین در CNET منتشر شده است اشتباه و پر از “خطاهای احمقانه” بود.

CNET باید فکر میکرد که ممکن است این اتفاق بیفتد، زیرا OpenAI یک هشدار منتشر کرد در مورد خروجی نادرست:

“ChatGPT گاهی اوقات پاسخ هایی با صدایی قابل قبول اما نادرست یا بی معنی می نویسد.”

CNET ادعا می کند که مقالات تولید شده توسط ماشین را قبل از انتشار برای بازبینی انسانی ارسال کرده است.

یک مشکل در بازبینی انسانی این است که محتوای ChatGPT طوری طراحی شده است که به طور متقاعدکننده ای درست به نظر برسد، که ممکن است داوری را که متخصص موضوع نیست فریب دهد.

۸. ChatGPT غیر طبیعی است زیرا واگرا نیست

مقاله تحقیقاتی، چقدر ChatGPT به متخصصان انسانی نزدیک است؟ نیز اشاره کرد که ارتباطات انسانی می تواند معنای غیرمستقیم داشته باشد که برای درک آن نیاز به تغییر موضوع دارد.

ChatGPT بیش از حد تحت اللفظی است، که باعث میشود پاسخها گاهی اوقات علامت را از دست بدهند زیرا هوش مصنوعی موضوع واقعی را نادیده میگیرد.

محققان نوشتند:

“پاسخهای ChatGPT به طور کلی بر روی سوال داده شده متمرکز است، در حالی که انسانها متفاوت هستند و به راحتی به موضوعات دیگر تغییر میکنند.

از نظر غنای محتوا، انسانها در جنبههای مختلف متفاوتتر هستند، در حالی که ChatGPT ترجیح میدهد روی خود سؤال تمرکز کند.

انسانها میتوانند بر اساس عقل و دانش خود به معنای پنهان زیر سؤال پاسخ دهند، اما ChatGPT بر کلمات تحت اللفظی سؤال متکی است…»

انسانها بهتر می توانند از سؤال تحت اللفظی که برای پاسخ دادن به سؤالات نوع «چه می شود» فاصله بگیرند.

برای مثال، اگر بپرسم:

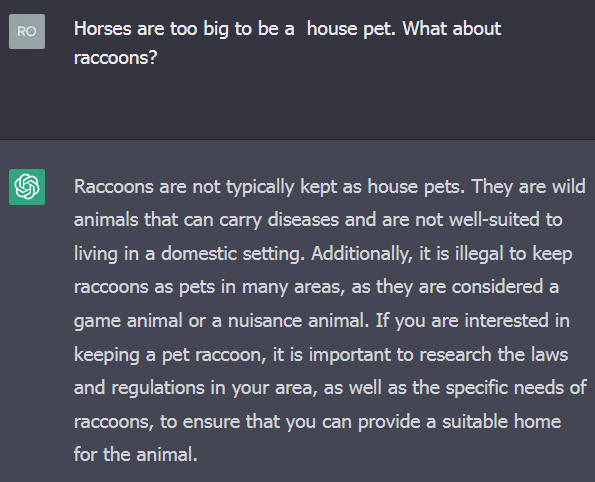

«اسب ها برای اینکه حیوان خانگی خانگی باشند خیلی بزرگ هستند. در مورد راکون ها چطور؟»

سوال بالا این نیست که آیا راکون حیوان خانگی مناسبی است یا خیر. سوال در مورد اندازه حیوان است.

ChatGPT به جای تمرکز بر اندازه، بر مناسب بودن راکون به عنوان حیوان خانگی تمرکز می کند.

نمایش یک پاسخ بیش از حد تحت اللفظی ChatGPT

عکس از ChatGPT، ژانویه ۲۰۲۳

عکس از ChatGPT، ژانویه ۲۰۲۳۹. ChatGPT حاوی تعصب نسبت به خنثی بودن است

خروجی ChatGPT عموماً خنثی و آموزنده است. این یک سوگیری در خروجی است که میتواند مفید به نظر برسد، اما همیشه مفید نیست.

مقاله تحقیقاتی که اخیراً مورد بحث قرار گرفتیم اشاره کرد که بی طرفی در مورد سؤالات حقوقی، پزشکی و فنی یک کیفیت ناخواسته است.

انسانها تمایل دارند هنگام ارائه این نوع نظرات، طرفی را انتخاب کنند.

۱۰. ChatGPT برای رسمی بودن تعصب دارد

خروجی ChatGPT دارای یک سوگیری است که از شل شدن آن و پاسخ دادن با عبارات معمولی جلوگیری می کند. در عوض، پاسخهای آن معمولاً رسمی هستند.

از سوی دیگر، انسانها تمایل دارند به سؤالات با سبک محاورهایتر، با استفاده از زبان روزمره و عامیانه پاسخ دهند – برخلاف فرمال.

ChatGPT از اختصاراتی مانند GOAT یا TL;DR استفاده نمی کند.

پاسخها همچنین فاقد نمونههایی از کنایه، استعاره و طنز هستند، که میتواند محتوای ChatGPT را برای برخی از انواع محتوا بیش از حد رسمی کند.

محققان می نویسند:

“…ChatGPT دوست دارد از حروف ربط و قیدها برای انتقال یک جریان منطقی فکر استفاده کند، مانند “به طور کلی”، “از طرف دیگر”، “اول،…، دوم، …، سرانجام” و غیره روشن است.

۱۱. ChatGPT هنوز در حال آموزش است

ChatGPT در حال حاضر هنوز در مرحله آموزش و بهبود است.

OpenAI توصیه میکند که تمام محتوای تولید شده توسط ChatGPT باید توسط یک انسان بازبینی شود، و این را بهعنوان بهترین روش فهرست میکند.

OpenAI پیشنهاد می کند انسان ها را در جریان نگه دارید:

«هرجا ممکن است، توصیه میکنیم قبل از استفاده از خروجیهای بازبینی انسانی در عمل استفاده کنید.

این امر بهویژه در حوزههای پرمخاطره و برای تولید کد بسیار مهم است.

انسان ها باید از محدودیت های سیستم آگاه باشند و به هر اطلاعاتی که برای تأیید خروجی ها نیاز است دسترسی داشته باشند (به عنوان مثال، اگر برنامه یادداشت ها را خلاصه می کند، یک انسان باید به راحتی به یادداشت های اصلی برای بازگرداندن دسترسی داشته باشد). ”

کیفیت های ناخواسته ChatGPT

واضح است که مشکلات زیادی در ChatGPT وجود دارد که آن را برای تولید محتوای بدون نظارت نامناسب می کند. این شامل تعصبات است و نمی تواند محتوایی ایجاد کند که طبیعی باشد یا حاوی اطلاعات واقعی باشد.

علاوه بر این، ناتوانی آن در احساس یا نوشتن افکار اصلی، آن را به انتخابی ضعیف برای تولید عبارات هنری تبدیل میکند.

کاربران برای تولید محتوای بهتر از محتوای پیشفرض که تمایل به خروجی آن دارند، باید دستورات دقیق را اعمال کنند.

در نهایت، بررسی انسان از محتوای تولید شده توسط ماشین همیشه کافی نیست، زیرا محتوای ChatGPT طوری طراحی شده است که درست به نظر برسد، حتی اگر درست نباشد.

این بدان معناست که مهم است که بازبینهای انسانی متخصصان موضوعی باشند که میتوانند بین محتوای صحیح و نادرست در یک موضوع خاص تشخیص دهند.

منابع بیشتر:

- مثالهای ChatGPT: 5 روشی که SEO و بازاریابان دیجیتال میتوانند از ChatGPT استفاده کنند

- چرا متخصصان سئو نیاز به تسلط دارند: انقلاب ChatGPT

- آیا استفاده ChatGPT از محتوای وب منصفانه است؟

تصویر ویژه توسط Shutterstock/fizkes