Google فناوری پیشرفتی به نام CALM را اعلام کرد که مدلهای زبان بزرگ (مانند GPT-3 و LaMDA) را بدون به خطر انداختن سطوح عملکرد سرعت میبخشد.

داده های آموزشی بزرگتر بهتر است اما هزینه دارد

مدلهای زبان بزرگ (LLM) بر روی مقادیر زیادی داده آموزش میدهند.

آموزش مدلهای زبان بر روی مقادیر بیشتری از دادهها منجر به یادگیری تواناییهای جدیدی در مدل میشود که همیشه برای آنها برنامهریزی نشده است.

به عنوان مثال، افزودن دادههای آموزشی بیشتر به یک مدل زبان میتواند به طور غیرمنتظرهای منجر به این شود که توانایی ترجمه بین زبانهای مختلف را به دست آورد، حتی اگر برای انجام این کار آموزش ندیده باشد.

این تواناییهای جدید، تواناییهای اضطراری نامیده میشوند، تواناییهایی که لزوماً برای آنها برنامهریزی نشدهاند.

یک مقاله تحقیقاتی متفاوت (PDF) درباره تواناییهای اضطراری بیان میکند:

«اگرچه دهها نمونه از تواناییهای نوظهور وجود دارد، در حال حاضر توضیحات قانعکنندهای برای اینکه چرا چنین تواناییهایی به شیوهای ظاهر میشوند، وجود دارد.»

آنها نمی توانند توضیح دهند که چرا توانایی های مختلف آموخته می شوند.

اما به خوبی شناخته شده است که افزایش حجم داده برای آموزش دستگاه به آن امکان می دهد توانایی های بیشتری به دست آورد.

عیب بزرگسازی دادههای آموزشی این است که برای تولید یک خروجی، قدرت محاسباتی بیشتری مصرف میشود، که باعث میشود هوش مصنوعی در زمانی که خروجی متن تولید میکند کندتر شود (لحظهای که «زمان استنتاج» نامیده میشود).

بنابراین، مبادله با هوشمندتر کردن هوش مصنوعی با دادههای بیشتر این است که هوش مصنوعی در زمان استنتاج نیز کندتر میشود.

مقاله تحقیقاتی جدید Google (مدلسازی زبان تطبیقی مطمئن PDF) مشکل را اینگونه توصیف می کند:

“پیشرفتهای اخیر در مدلهای زبان بزرگ مبتنی بر ترانسفورماتور (LLM) منجر به بهبود عملکرد قابل توجهی در بسیاری از وظایف شده است.

این دستاوردها با افزایش شدید اندازه مدلها همراه میشود، که احتمالاً منجر به استفاده آهسته و پرهزینه در زمان استنتاج میشود.”

مدلسازی زبان تطبیقی مطمئن (CALM)

محققان در Google راه حل جالبی برای سرعت بخشیدن به مدل های زبان پیدا کردند و در عین حال عملکرد بالا را نیز حفظ کردند.

راه حل برای قیاس کردن، تا حدودی شبیه تفاوت بین پاسخ دادن به یک سوال آسان و حل یک سوال دشوارتر است.

به یک سوال آسان، مانند رنگ آسمان، می توان با کمی فکر پاسخ داد.

اما یک پاسخ سخت مستلزم توقف و تفکر برای یافتن پاسخ است.

از لحاظ محاسباتی، مدلهای زبان بزرگ بین بخش سخت یک کار تولید متن و بخش آسان تمایزی قائل نمیشوند.

آنها با استفاده از قدرت محاسباتی کامل خود در زمان استنتاج، متن را برای هر دو بخش آسان و دشوار تولید می کنند.

راهحل Google مدلسازی زبان تطبیقی مطمئن (CALM) نام دارد.

کاری که این چارچوب جدید انجام میدهد این است که منابع کمتری را به بخشهای بیاهمیت یک کار تولید متن اختصاص میدهد و تمام قدرت را برای بخشهای دشوارتر اختصاص میدهد.

مقاله تحقیقاتی در مورد CALM مشکل و راه حل را اینگونه بیان می کند:

“پیشرفتهای اخیر در مدلهای زبان بزرگ مبتنی بر ترانسفورماتور (LLM) منجر به بهبود عملکرد قابل توجهی در بسیاری از وظایف شده است.

این دستاوردها با افزایش شدید اندازه مدلها همراه است که به طور بالقوه منجر به استفاده کند و پرهزینه در زمان استنتاج میشود.

اما در عمل، مجموعهای از نسلهای ساخته شده توسط LLM از سطوح مختلف دشواری تشکیل شده است.

در حالی که برخی پیشبینیها واقعاً از ظرفیت کامل مدلها بهره میبرند، ادامههای دیگر بیاهمیتتر هستند و میتوانند با محاسبه کاهش یافته حل شوند.

…در حالی که مدلهای بزرگ به طور کلی بهتر عمل میکنند، ممکن است برای هر ورودی برای دستیابی به عملکرد مشابه، مقدار یکسانی از محاسبات لازم نباشد (به عنوان مثال، بسته به اینکه ورودی آسان یا سخت باشد).»

Google CALM چیست و آیا کار میکند؟

CALM با تخصیص پویا منابع بسته به پیچیدگی بخش تک تک کار، با استفاده از یک الگوریتم برای پیشبینی اینکه آیا چیزی به منابع کامل یا جزئی نیاز دارد، کار میکند.

مقاله تحقیقاتی به اشتراک میگذارد که آنها سیستم جدید را برای کارهای مختلف پردازش زبان طبیعی (“خلاصه متن، ترجمه ماشینی و پاسخگویی به سوال”) آزمایش کردند و متوجه شدند که میتوانند استنتاج را تا حدود سه ضریب سرعت بخشند ( ۳۰۰٪.

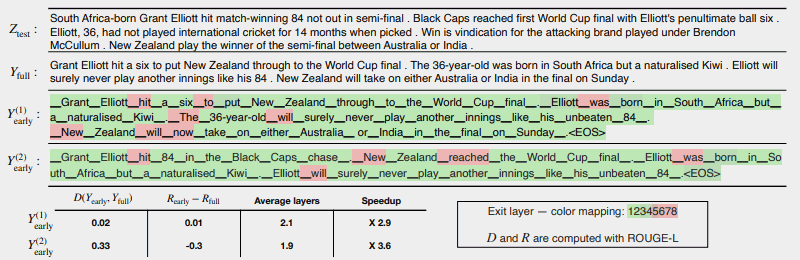

تصویر زیر نشان میدهد که سیستم CALM چقدر خوب کار میکند.

چند ناحیه قرمز رنگ نشان میدهد که دستگاه باید از تمام ظرفیت خود در آن بخش از کار استفاده کند.

مناطق سبز رنگ جایی هستند که دستگاه فقط کمتر از نیمی از ظرفیت را مصرف میکند.

قرمز = ظرفیت کامل/سبز = ظرفیت کمتر از نصف

این چیزی است که مقاله تحقیقاتی در مورد تصویر بالا میگوید:

«CALM با خروج زودهنگام در صورت امکان، و انتخابی با استفاده از ظرفیت کامل رمزگشا فقط برای چند توکن، تولید را تسریع میکند، که در اینجا در یک مثال CNN/DM با معیار اطمینان مبتنی بر softmax نشان داده شده است. Y (1) در اوایل و Y (2) در اوایل از آستانه های اطمینان متفاوتی برای خروج زودهنگام استفاده می کنند.

در زیر (sic) متن، سازگاری متنی و ریسک اندازهگیری شده هر یک از دو خروجی را به همراه افزایش بهرهوری گزارش میکنیم.

رنگها تعداد لایههای رمزگشایی مورد استفاده برای هر نشانه را نشان میدهند – سایههای سبز روشن کمتر از نیمی از کل لایهها را نشان میدهند.

فقط تعداد کمی از نشانههای انتخاب شده از ظرفیت کامل مدل استفاده میکنند (رنگ قرمز)، در حالی که برای بیشتر توکنها، مدل پس از یک یا چند لایه رمزگشایی (رنگ سبز رنگ) خارج میشود.»

محققان این مقاله را با ذکر این نکته به پایان رساندند که اجرای CALM تنها به حداقل تغییرات نیاز دارد تا بتواند یک مدل زبان بزرگ را برای سریعتر شدن تطبیق دهد.

این تحقیق مهم است زیرا راه را برای ایجاد مدلهای پیچیدهتر هوش مصنوعی باز میکند که بر روی مجموعه دادههای بزرگتر بدون تجربه سرعت پایینتر آموزش داده میشوند و در عین حال سطح عملکرد بالایی را حفظ میکنند.

اما ممکن است این روش بتواند برای مدلهای زبان بزرگی که بر روی دادههای کمتری آموزش دیدهاند نیز سودمند باشد.

به عنوان مثال، مدلهای InstructGPT، که ChatGPT یک مدل خواهر و برادر از آنهاست، بر روی تقریباً ۱.۳ میلیارد پارامتر آموزش دیدهاند، اما همچنان میتوانند از مدلهایی که بر روی پارامترهای بسیار بیشتری آموزش دیدهاند، بهتر عمل کنند.

محققان در نتیجه گیری خاطرنشان کردند:

“به طور کلی، چارچوب محاسباتی تطبیقی کامل ما برای LMها به حداقل تغییرات در مدل اساسی نیاز دارد و در عین حال که تضمینهای کیفیت دقیق را برای خروجی برآورده میکند، افزایش کارایی را ممکن میسازد.” =”۱۰″ id=”SEJ_300x250_UnderPost_7_i-parent” class=”content-unit sss2_sllo_o mmh-90-wrap”>

این اطلاعات درباره این مقاله تحقیقاتی به تازگی در وبلاگ هوش مصنوعی Google در تاریخ ۱۶ دسامبر ۲۰۲۲ منتشر شده است. تاریخ خود مقاله تحقیقاتی در ۲۵ اکتبر ۲۰۲۲ است.

دیدن این که آیا این فناوری به مدلهای زبانی بزرگ در آینده نزدیک راه پیدا میکند، جالب خواهد بود.

پست وبلاگ Google را بخوانید:

تسریع تولید متن با زبان تطبیقی مطمئن مدلسازی (CALM)

مقاله پژوهشی را بخوانید:

مدلسازی زبان تطبیقی مطمئن (PDF)

تصویر ویژه توسط Shutterstock/Master1305